本文書は、下記に示す私が筆頭著者を務める論文の翻訳文章です。日本医学放射線学会の一員として、日本の医療界全体において、議論していかなければならないAIの課題を網羅的に述べ、そしてそれに対する概念的な解決策を添えて、レビューとして出版しました。多くの医療関係者に広く用いていただけるように、放射線医学というよりは医療全体としての土台となるように意識的に書き上げたものです。共著には、AI界での権威である柿沼太一弁護士を迎えさせていただきました。本論文及び翻訳はご自由にお使いいただけるライセンスですので、皆さんの好きな形でご利用いただけると幸いです。医療AIに関わる皆様の少しでもお役に立てれば幸いです。

Springerなど各所ステークホルダーに許可を得て翻訳させていただいております。日本語にしにくい単語もたくさんあり、それらはカタカナ表記させていただいております。皆様のフィードバックを頂ければ、逐次修正していきたいと思います。

Ueda, D., Kakinuma, T., Fujita, S. et al. Fairness of artificial intelligence in healthcare: review and recommendations. Jpn J Radiol (2023). https://doi.org/10.1007/s11604-023-01474-3

邦題: 医療における人工知能の公平性: レビューと提言

原題: Fairness of artificial intelligence in healthcare: review and recommendations

序論

公平性は、人工知能(AI)の倫理の中核的な原則の一つである。近年、AIの公平性に関する取り組みが増加し、その改善の必要性を強調する多くの論文が発表されている。AIの開発や適用に関与するさまざまなバイアスは、AIの結果を誤って偏向させることで公平性に影響を及ぼす可能性がある。医療分野において、AIのバイアスと差別に関する研究は、多くの領域で行われている。世界医師会のジュネーブ宣言は、「年齢、疾患や障害、信条、民族、性別、国籍、政治的所属、人種、性的指向、社会的地位などの要因」が医師の患者に対する義務に影響を及ぼすべきではないと述べている。したがって、特定の患者に対してAIが適切に機能しない場合、公平性に関する懸念が生じる。

放射線医学におけるAI研究は、画像診断の親和性のため、医療分野での活発な研究分野である。AI関連の論文や医療機器の認証の数は年々増加している。これの一因として、放射線科医の世界的な不足が挙げられる。特に、日本は放射線学分野でのAIの使用に関する多くの論文を持っており、X線、マンモグラフィー、超音波、CT、MRI、PETなどが含まれる。この放射線学におけるAI論文の増加は、日本が経済協力開発機構(OECD)加盟国の中で、放射線科医の人口当たりの数が最も少なく、CTやMRIの機械の人口当たりの数が最も多いことと関連しているかもしれない。さらに、新型コロナウイルス感染症(COVID-19)のパンデミックの影響で、COVID-19関連の研究の数も増加しており、特にAIに焦点を当てた研究が顕著に増加している。

AIが臨床に導入されつつあるこの時代の医師として、全ての患者により良いケアを提供するために、医療におけるAIのバイアスから生じる公平性の懸念を意識しなければならない。このレビューは、AIの公平性に関する懸念の包括的な概観を提供し、AIのバイアスを軽減する戦略を議論し、公平なAI統合を確保するためのステークホルダー間の協力の必要性を強調することを目的としている。これにより、医療におけるAIの責任あるかつ公平な実装と展開について議論するための基盤を築く。

公平性の懸念

医療における公平性の定義

医療における公平性は、多次元的な概念であり、多様な患者集団の間での資源、機会、および結果の公平な分配を含む。公平性の概念は、正義、利益、および非有害の基本的な倫理原則に基づいている。医療制度は、差別なくすべての個人に高品質のケアへのアクセスを提供しなければならない。放射線医学の文脈において、AIの公平性は、社会的地位や民族的な違いに関係なく、すべての患者に対して正確な診断と治療を提供する偏見のないAIの開発と展開を指す。この公平性を達成するためには、AIのバイアスの潜在的な原因を包括的に理解し、これらのバイアスを軽減する戦略を開発することが必要である。

医療におけるAIのバイアス

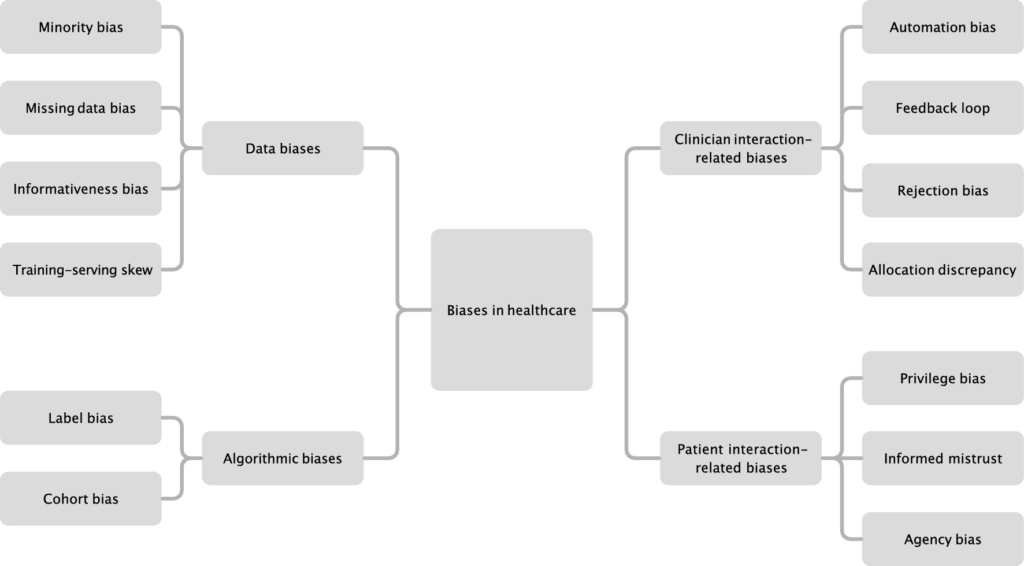

一般的に、AIのバイアスは主に二つの源から生じる:アルゴリズムのトレーニングに使用されるデータ(データバイアス)とアルゴリズム自体の固有の設計または学習メカニズム(アルゴリズムバイアス)。しかし、医療の文脈では、人間の相互作用と意思決定プロセスの複雑な性質のために、追加のバイアスが生じる可能性がある。これらの追加のバイアスは、AIと臨床医間の相互作用から生じるものと、AIと患者間の相互作用から生じるものの二つの種類に分類できる。これらのバイアスの概要は、図に示されている。

データバイアス

データバイアスは、AIトレーニングで使用されるデータの収集と組織化に関連する問題を指し、公平性と正確性に有害な影響を及ぼす可能性がある。データバイアスの種類には、マイノリティバイアス、欠損データバイアス、情報性バイアス、および学習時と臨床時のズレ(Training-serving skew)が含まれる。マイノリティバイアスは、データセット内の保護されたグループのメンバーの数が、AIが正確な統計的パターンを学習するのに十分でない場合に発生する。これにより、アルゴリズムがこれらの代表性の低いグループに適用されたときのパフォーマンスの低下とバイアスのある結果が生じる可能性がある。例えば、多くの心血管リスク予測アルゴリズムは、主に男性患者のデータを基にトレーニングされてきた。これにより、異なる症状とリスク要因を持つ女性患者のリスク評価が不正確となっている。欠損データバイアスは、保護されたグループからのデータが非ランダムに欠落している場合に発生し、AIが正確な予測を生成するのが困難となる。例えば、接触隔離中の患者が他の患者よりも生命徴候の記録が少ない場合、アルゴリズムは臨床的な悪化を特定するのが困難となる可能性がある。情報性バイアスは、特定の保護されたグループに対して検出に使用される特徴が明確でないため、予測が行われるときにその情報性が低下する場合に発生する。例えば、濃い肌の患者の画像からメラノーマを特定することは、薄い肌の患者よりも困難である。学習時と臨床時のズレ(Training-serving skew)は、AIトレーニングに使用されるデータと展開中に使用されるデータとの間の不一致を指す。これは、選択バイアスによる非代表的なトレーニングデータや、トレーニングデータの人口の有病率と異なる患者へのモデルの展開から生じる可能性がある。胸部X線から肺炎を診断するためのAIのトレーニングに関する研究では、トレーニングデータが収集された機関からの未見のデータでのパフォーマンスは、外部の病院から収集されたデータでのパフォーマンスよりも著しく高かった。この一般的なシナリオは、内部テストデータに基づいてAIのパフォーマンスの推定が、外部データでの実際のパフォーマンスを過大評価する可能性があることを意味する。

アルゴリズムバイアス

アルゴリズムバイアスは、AIの開発と実装に関連する問題を指し、公平性と効果性に悪影響を及ぼす可能性がある。データバイアスのない代表的なデータであっても、AIはその固有の設計や学習メカニズムのためにバイアスを示すことができる。アルゴリズムのバイアスには、ラベルバイアスとコホートバイアスが含まれる。ラベルバイアスは、テストの紹介と解釈のバイアスを含む広範な概念である。これは、AIのトレーニングが一貫しないラベルを使用する場合に発生する。これは、医療の格差に影響される可能性があるむしろ普遍的に受け入れられた真実に基づいている。これにより、AIのアルゴリズム内の不正確または一貫しない情報に基づいてバイアスのある意思決定が行われる可能性がある。例えば、患者の医療ニーズを予測するために使用される商用利用可能なアルゴリズムで、顕著な人種的バイアスが観察されている。いくつかのバイアスが影響を受けたが、このアルゴリズムのバイアスの主要な要因の一つは、設計であり、医療ニーズの代理としてコストを使用したことで、同様の状態を持つ白人と比較して、黒人患者のニーズを過小評価する結果となった。コホートバイアスは、他の潜在的に保護されたグループやさまざまな粒度のレベルを考慮せずに、伝統的または簡単に測定可能なグループに基づいてAIが開発される場合に発生する。例えば、レズビアン、ゲイ、バイセクシャル、トランスジェンダー、クィアまたは疑問、インターセックス、無性愛、およびその他(LGBTQ+)の集団内で、精神的健康の障害が過小診断または誤診されている。これの一因として、アルゴリズムがしばしばLGBTQ+の集団の粒度を考慮せず、生物学的な男性と女性に関する情報のみに依存していることが挙げられる。このようなデータでトレーニングされたAIは、これらの集団の精神的健康の問題を見逃すか誤診する可能性があり、既存の精神医療の格差を継続的に拡大する可能性がある。

臨床医との相互作用に関連するバイアス

医療専門家がAIと相互作用するとき、相互作用に関連するバイアスが発生する可能性があり、アルゴリズムのパフォーマンス、公平性、および採用に影響を及ぼす可能性がある。そのようなバイアスの一つは、オートメーションバイアスであり、これは、タスクが医療専門家からAIプログラムに移行されるときのAIへの過度な依存を指す。アルゴリズムへの過度な自信は、不正確な予測に基づいて不適切な行動を引き起こす可能性がある。一つの研究では、不正確なAIのアドバイスが、すべての専門家レベルでの放射線科医のマンモグラムの読み取りパフォーマンスに悪影響を及ぼすことがわかった。経験の浅い放射線科医は、不正確なAIの提案に従う可能性が高い。相互作用に関連する別のバイアスは、フィードバックループである。これは、臨床医がAIの推奨を受け入れるとき、それが間違っている場合でも、アルゴリズムが同じ間違いを再学習し、繰り返すことになる。拒絶バイアスは、過度なアラートに対する意識的または無意識的な鈍感化を指す。アラートの疲れは、このバイアスの一形態であり、臨床医は、多数の誤報警に圧倒されることにより、重要なアラートを無視する可能性がある。最後に、保護されたグループのための陽性の予測値が不釣り合いに低い場合、AIが必要なリソース、例えば臨床的な注意や社会的サービスを保留することになる。このようなリソースの配分の不一致は、影響を受けるグループの間でのケアと結果の格差を拡大する可能性がある。

患者との相互作用に関連するバイアス

患者とAIまたはそれを取り入れるシステムとの相互作用に関連するバイアスには、特権バイアス、情報に基づく不信、およびエージェンシーバイアスが含まれる。特権バイアスは、特定の集団がケアの設定でAIにアクセスできない場合、またはこれらのアルゴリズムがすべての集団に利用可能でない技術やセンサーを必要とする場合に発生する。これにより、AI駆動型の医療の利益の不平等な分配が生じ、既存の医療の格差が悪化する可能性がある。情報に基づく不信は、保護されたグループが医療における歴史的な搾取と非倫理的な実践のためにAIに対して持っている可能性のある懐疑心を指す。この不信は、これらの患者がケアを避けるか、臨床医やAIを使用するシステムから意図的に情報を隠すことにつながる可能性がある。エージェンシーバイアスは、保護されたグループがAIの開発、使用、および評価において声を持たない場合に生じる。これらのグループは、AIのバイアスを検出し、懸念を声に出し、変化をもたらすために必要なアクセス、リソース、教育、または政治的影響力を欠いている可能性がある。このエージェンシーの欠如は、保護されたグループのニーズと視点を考慮するのに不適切なAIをもたらす可能性があり、医療の結果におけるバイアスと格差を引き起こす可能性がある。

バイアスを緩和する戦略

多様で代表的なデータ

AIのバイアスを緩和する最も効果的な方法の一つは、AIの開発とトレーニング中に多様で代表的なデータセットを使用することを確実にすることである。このプロセスは、目標とする人口の人口統計、特性、医療ニーズ、および潜在的な格差を正確に反映するために、広範な情報源からのデータを慎重に収集および組み込むことを含む。この多様性は、多くの患者の要件に対応する能力を持つAIシステムを開発するためだけでなく、AI駆動型の医療ソリューションへの信頼と信頼を育むためにも重要である。さまざまな患者集団、年齢層、疾患の段階、文化的および社会経済的背景、および医療の設定からのデータを組み込むことで、AIは、より高い精度と文脈的理解で、広範な患者の状態を認識、診断、および治療することを学ぶことができる。この包括的なアプローチは、AIシステムでの潜在的なバイアスの発生を防ぐことで、格差の削減と医療結果の公平性の促進をもたらす。さらに、多様で代表的なデータセットは、AIアルゴリズムがさまざまなシナリオで厳密にテストされることを確実にし、その全体的なパフォーマンスと有用性を向上させる。これにより、医療提供者はAI駆動型の診断および治療の推奨に依存することができ、患者のケアの向上および臨床医の業務負荷の削減につながる。

アルゴリズムの監査と検証

定期的な監査とAIの検証は、潜在的なバイアスを識別し、対処し、AIシステムが多様な医療の設定で公平で正確で効果的であることを確実にするために、重要な役割を果たす。外部の専門家や組織による独立した監査を行い、AIの公平性、正確性、およびパフォーマンスを評価し、識別されたバイアスを修正するための調整を行うことができる。医療の風景は絶えず変化しているため、高いパフォーマンスを持つAIアルゴリズムが将来もその高いパフォーマンスを維持する保証はない。異なる患者集団や状態でのAIの有効性を確認するための検証研究が不可欠である。アルゴリズムの品質管理のための専用部門を病院内に設立することが提唱されている。この部門は、AIのパフォーマンスを継続的に監視し、潜在的なバイアスを識別し、アルゴリズムに必要な更新を行う責任を持つべきである。この積極的なアプローチは、AIシステムが説明責任を果たし、すべての患者に対して正確で公平なケアを提供する効果を維持することを確実にする。医療AIの普及が増加する中で、実践者は、アルゴリズムの開発プロセス中および展開後に、過小診断率やその他の健康格差などの主要な指標を評価する必要がある。この継続的な評価は、新たに発生する問題を識別し、修正するのに役立ち、AIシステムが効果的かつ公平に患者に奉仕し続けることを確実にする。

臨床医と患者の両方への教育

AIに固有のバイアスについての臨床医と患者の教育は、共有の理解を育むためおよび医療における公平性を促進するために不可欠である。この教育プロセスは、潜在的なバイアスに関する認識を高めること、それらに対処するためのベストプラクティスを共有すること、および医療の意思決定におけるAIの意味に関するオープンな議論を奨励することを含む。AIのバイアスを理解している臨床医は、AI生成の結果に過度に依存することを避け、より正確な情報に基づいて意思決定を行うことができる。この高まった認識により、医療専門家はAIの推奨を批判的に評価し、潜在的なリスクと利益を検討し、患者のケアの意思決定を行う際に他の情報源を考慮することができる。さらに、臨床医は、AIシステムの開発と評価に参加し、モデルに自らの専門知識と経験を組み込むことで、その正確性と信頼性をさらに向上させることができる。AIのバイアスを理解している患者は、より情報に基づいた満足のいく決定を下すことができる。AI生成の推奨の潜在的な制限とバイアスを認識することにより、患者は治療オプションに関して医療提供者との意味のある会話を持つことができ、ケアにおいてよりアクティブな役割を果たすことができる。このエンパワーメントは、患者中心のケアを促進し、医療の意思決定を行う際に、個々の好み、価値観、および状況が考慮されることを確実にする。AIの継続的な学習と改善の文化を育むために、医療専門家と患者の間でのフィードバックと協力のチャンネルを作成することが不可欠である。これは、ワークショップ、会議、オンラインフォーラム、または多様な視点と経験を持ち寄るための学際的な協力を通じて達成することができる。知識、洞察、およびベストプラクティスを共有することで、彼らは一緒にバイアスを識別し、対処し、すべての患者のニーズによりよく奉仕するためにAIシステムを継続的に洗練することができる。

ステークホルダー間の協力

医師、AI研究者、およびAI開発者

医師、AI研究者、およびAI開発者間の協力は、AIの公平性の懸念に対処するために不可欠である。医師の参加は、AI研究者にとって貴重な専門知識と洞察を提供することができる。医師との専門知識を通じて、実際の医療実践でのAIの使用経験を共有することで、改善のサイクルを実現することができる。共同で作業することで、ステークホルダーは潜在的なバイアスを特定し、それらを軽減するための効果的な戦略を開発することができ、AIが公平で公正で効果的であることを確保することができる。さらに、AIのバイアスに関する実証的な研究は、大規模なデプロイされたアルゴリズムが一般的に独自のものであるため、独立した研究者が分析するのは難しい。これにより、バイアスを適切に評価することが難しくなり、AI研究者だけでなく、企業のAI開発者の積極的な協力が不可欠となる。

政策立案者および規制当局

政策立案者および規制当局は、医療におけるAIの開発と展開を統制する包括的なガイドライン、基準、および規制を確立することで、AIの公平性を確保する上で重要な役割を果たす。積極的に方針を形成することで、公平性と包括性を念頭に置いてAIが設計、トレーニング、および検証のためのフレームワークの開発を促進することができる。AIの透明性と説明責任を育成することも、彼らの責任の重要な側面である。政策立案者および規制当局は、AI開発者に彼らの方法論、データソース、およびパフォーマンス指標を開示する要件を実施することで、AIのより良い評価と比較を可能にすることができる。さらに、政策立案者および規制当局は、AIの革新と研究への資源と資金を割り当てることができるだけでなく、AI駆動型の医療における公平性と平等性の問題に取り組むこともできる。健康の平等に焦点を当てたAI技術の開発を奨励する方針を策定することで、政策立案者と規制者はバイアスを最小限に抑え、背景や状況に関係なく、すべての患者がAIの恩恵を受けることを確保することができる。これにより、AI駆動型のソリューションが患者の結果を向上させ、高品質なケアへのアクセスの格差を削減することができるより公平な医療システムに貢献することができる。

患者および擁護団体

患者および擁護団体は、貴重な洞察と直接の経験を対話に提供することで、AIの公平性を促進する上で重要な機能を果たす。彼らは、多様な患者集団のニーズと好みに関する貴重な洞察を提供することができ、AIがさまざまなコミュニティが直面する特定の課題に対応することを確実にする。AIの出力に直接影響を受ける患者として、彼らはAIが潜在的なバイアスと医療結果の格差に対してどのように対処するかに関心を持っている。医師、AI研究者、およびAI開発者が患者および擁護団体と協力することで、さまざまな患者集団が直面する独自の課題と懸念をより深く理解し、個々のニーズに合わせた公平で効果的なAIソリューションの開発を促進することができる。これにより、AI駆動型の医療における信頼を築くのにも役立つ。AIの設計、実装、および評価において彼らに発言権を与えることで、組織は患者の懸念に対応し、透明性を向上させることで患者へのコミットメントを示すことができる。

専門家協会

専門家協会は、AI駆動型の医療ソリューションの開発と実装を指導し、倫理的な課題に対処し、ベストプラクティスを促進する上で中心的な役割を果たす。ガイドライン、基準、および倫理的なフレームワークを確立し、学際的な協力を促進し、すべてのステークホルダー間でのオープンな対話を促進することで、このギャップを埋める。彼らのユニークな立場により、公平で透明な方針と実践の開発に貢献するとともに、AI技術が責任を持って、公平に、そして患者の最善の利益のために開発および展開されることを確保することができる。

提言と今後の方向性

AIの公平性に関する医療のベストプラクティス

医療におけるAIの公平性を促進し、すべての患者に公平で正確なケアを確保するために、バイアスを複数のレベルで対処するとともに、倫理的、法的、実践的な懸念を取り扱う包括的な戦略の策定が必要である。このアプローチは、公平なAI駆動の医療ソリューションを達成するための主要なステークホルダー間の協力を促進すべきである。以下に、公平かつ公正なAI駆動の医療ソリューションを確保することを目的とした、FAIR(医療における人工知能の公平性の推奨事項)原則としての提言を示す。

1. AI開発における多様で代表的なデータの確保

AIの開発とトレーニング中に多様で代表的なデータを利用する。これにより、AIシステムは患者の状態をより良く認識、診断、治療することができ、医療の結果の格差を減少させ、医療の公平性を促進することができる。

2. AIアルゴリズムの独立した監査と検証

独立した専門家や組織による定期的な監査とAIアルゴリズムの検証を実施する。これにより、評価プロセスの客観性と透明性が確保され、潜在的なバイアスを特定し、アルゴリズムの必要な調整を行うことができる。病院内にアルゴリズムの品質管理のための専用システムを設立し、AIのパフォーマンスを継続的に監視し、潜在的なバイアスを特定し、それに応じてアルゴリズムを更新する。

3. 臨床医と患者へのAIのバイアスに関する教育

AIに固有のバイアスについての臨床医と患者への教育を行い、必要に応じて継続的な教育を提供する。これにより、共有の理解が促進され、医療の意思決定におけるAIの意義に関するオープンな議論が奨励される。これは、ワークショップ、会議、オンラインフォーラム、および学際的な協力を通じて達成することができる。

4. データのプライバシーとセキュリティ対策の強化

HIPAAやGDPRなどの既存の法的枠組みを順守することを確実にするために、データのプライバシーとセキュリティ対策を強化する。データの使用、保管、共有に関する透明なコミュニケーションプロトコルを開発し、患者がAI駆動の医療イニシアティブへの参加に関する意思決定を行う際に十分に情報を得ることができるようにする。

5. 責任と説明責任の枠組みの確立

医師、AI開発者、および医療機関の役割と責任を明確に定義する堅牢な責任と説明責任の枠組みを確立すべきである。AIアルゴリズムの継続的なフィードバックと改善を奨励し、透明性を維持しながら、AIソリューションの意図された使用と制限に関するガイダンスを提供する。

6. AIの透明性と説明可能性の強化

解釈可能なアルゴリズムの開発、モデルの意思決定プロセスの可視化、およびAIの予測の説明を提供することにより、AIの透明性と説明可能性を強化する。説明可能なAIの制限を認識し、AI生成の出力への過度な依存を防ぐための潜在的なバイアスを対処する。

7. 医師、AI研究者、および開発者間の協力

医師、AI研究者、および開発者間の協力を促進し、専門知識を共有し、潜在的なバイアスを特定し、それらを軽減するための戦略を開発する。AIのバイアスに関する独立した研究をサポートし、アルゴリズムの公平性を向上させるために、AI企業の積極的な参加が奨励されるべきである。

8. 政策立案者と規制当局の関与

政策立案者と規制当局は、AIの公平性を確保するための包括的なガイドライン、標準、および規制を開発することにより関与する。透明性と説明責任を促進し、AI駆動の医療における研究と革新をサポートするためのリソースを割り当てる。

9. AIの開発と評価における患者と擁護団体の参加

AIソリューションの設計、実装、および評価に患者と擁護団体を関与させる。彼らの洞察と経験を活用して、固有の課題に対応し、個々のニーズに合わせた公平なAIソリューションの開発を促進する。

10 .専門家協会のサポート

専門家協会は、ガイドライン、標準、および倫理的な枠組みを確立し、学際的な協力を促進し、すべてのステークホルダー間でのオープンな議論を奨励することで、AI駆動の医療ソリューションの開発と実装を指導する役割を果たす。彼らのユニークな立場は、公平で透明な方針と実践の開発に貢献するとともに、AI技術が責任を持って、公平に、そして患者の最善の利益のために開発および展開されることを確保する。

これらの提言を実施し、データとアルゴリズムのバイアスに対処することで、AI駆動の医療分野のステークホルダーは、信頼、透明性、および包括性を促進することができる。これにより、AI技術が、彼らの違いに関係なく、すべての患者の利益のために、倫理的に、責任を持って、公平に開発および展開されることが確保される。最終的に、このアプローチは、より公平な医療システムに貢献し、患者の結果を向上させる。

研究のギャップと今後の作業

AIのバイアスと公平性に関する懸念を対処するためのいくつかの研究のギャップと今後の研究の機会が存在する。患者のケアと結果を向上させるAIの潜在能力を探るために、ランダム化比較試験を実施すべきである。これらの試験には、異なる人口統計学的グループの特定のニーズに合わせた多様な人口とAIを含めるべきである。医療におけるAIの採用の長期的な影響を、患者の治療、結果、および医師のワークロードについて調査すべきである。モデルは、時間の経過とともに現れる可能性のあるバイアスに対処するために、定期的に監視されるべきである。医療専門家と患者がAI生成の予測をよりよく理解し、AIへの信頼を育て、その倫理的な展開を確保するために、説明可能性と透明性のための新しい技術の開発が必要である。

結論

本レビューでは、まず医療分野におけるAIの公平性を定義し、さまざまなバイアスと例、および潜在的な対策を紹介し、ステークホルダーとの協力の重要性を強調した。その後、重要な倫理的および法的問題について議論した。結果として、ベストプラクティスをFAIR提言としてまとめた。これには、多様で代表的なデータの準備、AIの継続的な検証、医師と患者の教育、および学際的な協力の重要性の強調が含まれる。各ベストプラクティスの実施は困難であるが、医療分野でのAI統合が進むにつれて、これらの取り組みはますます重要になってきた。さらに、AI技術は進化し続けており、状況は絶えず変わり、新しい課題が次々と現れている。Chat Generative Pre-trained Transformer(ChatGPT)のようなツールの登場は、ホワイトカラーの仕事を大きく変えると予想され、医師も例外ではない。現在、医師は新しい技術に迅速に対応する柔軟な思考が求められる時代にある。

AIの登場以来、現代社会のいくつかの側面に影響を与え、顕著な進歩をもたらしてきた。医療分野もこの変化の波にさらされることは自明で、特に放射線学はAIの力を引き出すことができる位置にある。このユニークな位置にあるため、放射線学のコミュニティは、医療にAIを積極的に統合する経験を共有する重要な責任がある。他の医療専門分野に貴重なガイダンスと洞察を提供する。AIの実装の先駆者として、放射線科医は医療におけるAIの公平性を主張すべきである。AIの採用と展開に関連する課題を克服する初期の経験は、他の医療専門家のためのロードマップとして役立つ。そうすることで、AIが彼らの背景に関係なくすべての患者に利益をもたらし、社会の大きな利益に貢献することを確保することができる。